Hai un compito da affidare a un’IA. Chiedi e basta, o prima le mostri cosa vuoi?

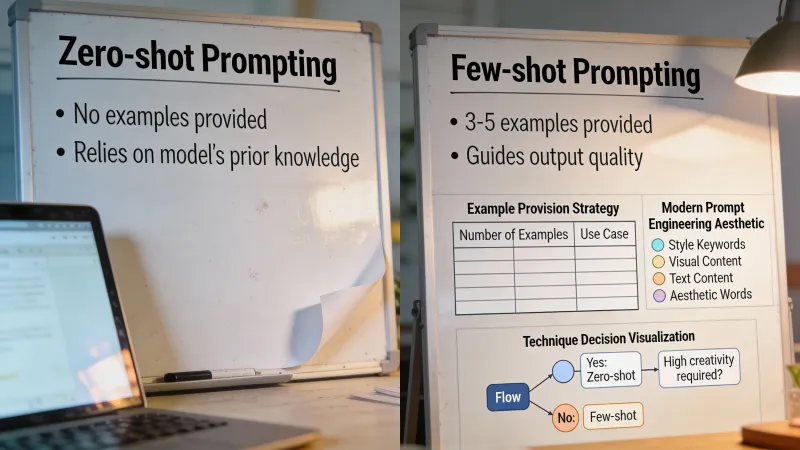

Questa è la domanda zero-shot vs few-shot. Zero-shot significa chiedere direttamente, senza esempi. Few-shot significa dare uno o più esempi prima della richiesta vera. I nomi arrivano dalla ricerca sull’apprendimento automatico, ma il concetto è semplice: mostrare vs spiegare.

La maggior parte delle persone non usa mai esempi oppure li usa per tutto. Entrambe le cose sono sbagliate. La risposta dipende da cosa stai chiedendo, da quale modello stai usando e dal fatto che il formato conti più del contenuto.

Approccio prima gli esempi

Il prompting few-shot funziona per riconoscimento di schemi. Mostri all’IA com’è un buon risultato e lei rispecchia quello schema sul nuovo input. È particolarmente potente quando hai bisogno di un formato, un tono o una struttura specifici che sono difficili da descrivere a parole.

Metti che ti servano descrizioni prodotto per un sito e-commerce. Potresti spiegare che vuoi descrizioni brevi, incisive, con le caratteristiche chiave in un ordine preciso. Oppure puoi semplicemente mostrarne una:

Tazza da viaggio in ceramica Mantiene il caffè caldo per 4 ore. Entra nei portabicchieri standard. Lavabile in lavastoviglie. Disponibile in 6 colori.

Poi chiedi una descrizione di una borraccia in acciaio inox. L’IA ora ha un modello di riferimento. Corrisponde alla lunghezza, alla struttura delle frasi, al livello di dettaglio. Nessuna ambiguità su ciò che stai cercando.

Un commentatore su Hacker News l’ha detto in modo semplice: “In general, showing an example of correct output (one shot prompting) can greatly improve output format consistency.”

Questo è il vantaggio centrale. Coerenza. Quando ti serve che l’IA produca più output nello stesso formato, gli esempi battono quasi sempre le istruzioni.

Quando gli esempi cambiano tutto

I vantaggi del prompting few-shot possono essere enormi. In un caso studio di codifica medica, aggiungere coppie esempio-etichetta ai prompt ha migliorato l’accuratezza dallo 0% al 90%. Non è un refuso. Lo stesso modello è passato da completamente sbagliato a quasi perfetto solo perché prima ha visto qualche esempio.

Ma questo è uno scenario ideale. Le ricerche raccolte da PromptHub mostrano rendimenti decrescenti dopo circa due o tre esempi. Vedi grandi miglioramenti con i primi, poi arriva un plateau. Aggiungere dieci esempi invece di tre raramente aiuta e potrebbe persino peggiorare, intasando il prompt.

Uno studio della University of London sulla correzione automatica dei bug ha trovato qualcosa di controintuitivo: il framework MANIPLE ha ottenuto un miglioramento del 17% nelle correzioni riuscite ottimizzando quali esempi includere, ma aggiungere più esempi a volte degradava le prestazioni. Il prompt diventava più rumoroso, non più intelligente.

Il caso sorprendente contro gli esempi

Qui la cosa diventa interessante. Le regole stanno cambiando con i modelli di ragionamento più recenti.

La serie o1 di OpenAI e modelli simili focalizzati sul ragionamento in molti casi rendono peggio con gli esempi. Ricerche citate da PromptHub hanno rilevato che il prompting 5-shot ha ridotto le prestazioni di o1-preview rispetto a una base con prompt minimale. La documentazione di DeepSeek-R1 afferma esplicitamente che il few-shot prompting “consistently degrades its performance.”

Perché? Questi modelli sono progettati per ragionare sui problemi da soli. Dare esempi può vincolare il loro ragionamento o mandarli sul percorso sbagliato. Funzionano meglio quando descrivi cosa vuoi e lasci a loro il modo di arrivarci.

Questo conta perché il settore si sta spostando verso modelli di ragionamento. Se stai usando o1, o3-mini o simili, prova prima senza esempi. Aggiungili solo se il formato dell’output ha bisogno di correzioni.

Il problema modello per modello

C’è un’altra complicazione. Gli esempi migliori per un modello potrebbero non essere i migliori per un altro.

Aickin, fondatore di Libretto, ha condotto esperimenti per verificare se gli esempi con le prestazioni migliori in un modello fossero i migliori anche in un altro. Il risultato è stato chiaro: “Most of the time, the answer was no, even between different versions of the same model.”

L’implicazione pratica è dura. Probabilmente devi ottimizzare gli esempi modello per modello e rifare quel lavoro ogni volta che esce una nuova versione. Quei tre esempi perfetti che hai creato per GPT-4 potrebbero non trasferirsi a GPT-4o o Claude 3.5.

Per la maggior parte delle persone, questo significa tenere gli esempi semplici e non sovra-ottimizzare. Più specifici sono i tuoi esempi, più è probabile che si rompano quando cambi modello o quando il modello viene aggiornato.

Mostrare o spiegare: quando funziona ciascuno

Dimentica le regole rigide. Pensa a cosa stai davvero cercando di ottenere.

Gli esempi funzionano meglio quando:

Il formato è tutto. Se ti servono JSON, tabelle markdown o un modello specifico da compilare, un esempio spesso batte paragrafi di istruzioni. L’IA vede la struttura e la replica.

Lo stile è difficile da descrivere. “Scrivi con la voce del nostro marchio” è vago. Mostrare tre frasi nella voce del tuo marchio è concreto. Lo schema è più facile da imitare della descrizione.

Stai facendo compiti ripetitivi. Ti servono venti descrizioni prodotto? Dai due esempi, ottienine altre diciotto nello stesso formato. La coerenza si moltiplica.

Il modello è un LLM standard come GPT-4 o Claude. Questi modelli sono addestrati a seguire schemi. Rispondono bene a un approccio mostra-non-dire.

Salta gli esempi quando:

Il compito richiede ragionamento. Problemi di matematica, rompicapi logici, debug del codice, analisi strategica. In questi casi, spiega cosa vuoi e lascia pensare il modello. Aggiungere esempi può vincolare il suo approccio o introdurre errori dalla soluzione specifica del tuo esempio.

Stai usando un modello di ragionamento. o1, o3-mini, DeepSeek-R1. Questi modelli generano internamente la loro catena di pensiero. Gli esempi possono interferire con questo processo.

Il compito è semplice. “Riassumi questo articolo in tre frasi” non ha bisogno di un esempio. L’istruzione è già abbastanza chiara. Aggiungere esempi brucia solo token senza migliorare l’output.

Ti serve creatività, non coerenza. Se vuoi che l’IA ti sorprenda, gli esempi restringono lo spazio degli output possibili. Le stai mostrando cosa è consentito invece di cosa è possibile.

Il test del mondo reale

La teoria è utile. La pratica è meglio.

Fai un esperimento semplice prima di impegnarti su un approccio. Prendi il tuo compito, eseguilo tre volte in zero-shot e tre volte con due esempi. Confronta gli output. Gli esempi hanno migliorato la qualità? Hanno migliorato la coerenza? Hanno cambiato qualcosa?

Spesso la risposta è: “Gli esempi hanno aiutato il formato ma non la qualità dei contenuti.” È un’informazione utile. Ti dice quando vale la pena investire negli esempi e quando conviene investire invece in istruzioni migliori.

Alcuni professionisti trovano che il punto ottimale sia un esempio per il formato più istruzioni dettagliate per tutto il resto. Ottieni coerenza strutturale dall’esempio lasciando che le istruzioni guidino la sostanza.

Il calcolo dei costi

Gli esempi non sono gratis. Ogni esempio che aggiungi costa token a ogni chiamata API. Con Claude Haiku o GPT-4o-mini, il costo è trascurabile. Con GPT-4 o Claude Opus, si accumula.

Il calcolo cambia in base al volume. Se esegui un prompt una volta, aggiungi pure tutti gli esempi che vuoi. Se lo esegui migliaia di volte al giorno, ogni token conta.

Minimaxir ha osservato su Hacker News che l’economia favorisce il prompting few-shot più che mai: “You will often get better results with few-shot prompting (with good examples) on a modern LLM than with a finetuned LLM.” I token in input sono diventati economici, soprattutto con modelli come Claude Haiku. Il costo di aggiungere esempi è crollato.

Ma il confronto non riguarda solo il costo dei token. Il fine-tuning di un modello costa da 4 a 6 volte di più rispetto all’uso API standard, secondo i prezzi di OpenAI. Se stai scegliendo tra fine-tuning e usare molti esempi, spesso gli esempi vincono sul costo anche con i token extra.

La pericolosa via di mezzo

L’approccio peggiore è aggiungere esempi senza chiederti se aiutano davvero.

Prompting da cargo cult. Hai letto da qualche parte che bisogna “aggiungere sempre esempi” e ora ogni prompt ha tre esempi, che siano rilevanti o no. L’IA si confonde su cosa sia istruzione e cosa sia contesto. L’output peggiora, non migliora.

Oppure l’opposto: hai interiorizzato che i prompt debbano essere “chiari e diretti” e quindi non mostri mai esempi anche quando il formato è ciò che conta. Finisci per scrivere paragrafi su strutture di tabelle quando un solo esempio comunicherebbe la stessa cosa in due righe.

La competenza non sta nel memorizzare regole. Sta nel riconoscere in quale situazione ti trovi.

Mescolare gli approcci

La scelta tra esempi e istruzioni non è binaria. Puoi spiegare cosa vuoi e poi mostrarlo.

Per l’estrazione di documenti, potresti scrivere: “Estrai da questi moduli nome cliente, email, valutazione e principale punto di feedback. Formatta come JSON.”

Poi aggiungi un esempio che mostri il formato. L’istruzione spiega il compito. L’esempio fissa la struttura dell’output. Ottieni sia chiarezza sia coerenza.

Questo approccio ibrido funziona particolarmente bene quando: il formato è specifico (usa l’esempio), ma il ragionamento dietro le decisioni conta (usa l’istruzione). Da soli non bastano. Insieme coprono aspetti diversi di quello che ti serve.

Cosa conta davvero

Dopo tutta la ricerca e la sperimentazione, alcune cose sono chiare.

Gli esempi aiutano soprattutto con formato, coerenza e stile. Se queste sono le tue priorità, usali. Se le tue priorità sono qualità dei contenuti e ragionamento, gli esempi potrebbero non aiutare e potrebbero persino danneggiare.

Due o tre esempi di solito bastano. Oltre raramente aggiunge valore e potrebbe aggiungere rumore. La ricerca di PromptHub mostra che i rendimenti decrescenti arrivano in fretta.

Testa sul tuo compito reale con il tuo modello reale. Le medie della ricerca nascondono variazioni enormi. Quello che funziona nella codifica medica potrebbe non funzionare per il testo marketing.

E osserva cosa succede quando i modelli vengono aggiornati. I tuoi esempi ottimizzati con cura potrebbero richiedere una ricalibrazione. Il miglior prompt few-shot del mese scorso oggi potrebbe essere solo nella media.

Se ti porti via una sola cosa, che sia questa: la differenza tra zero-shot e few-shot non riguarda quale tecnica sia “migliore”. Riguarda se riconoscimento di schemi o ragionamento serva meglio il tuo compito. A volte vuoi che l’IA copi una struttura. A volte vuoi che pensi. Capire quando vale l’uno o l’altro è tutto il gioco.